Data science

Изучи Data science углубленно за 6 месяцев

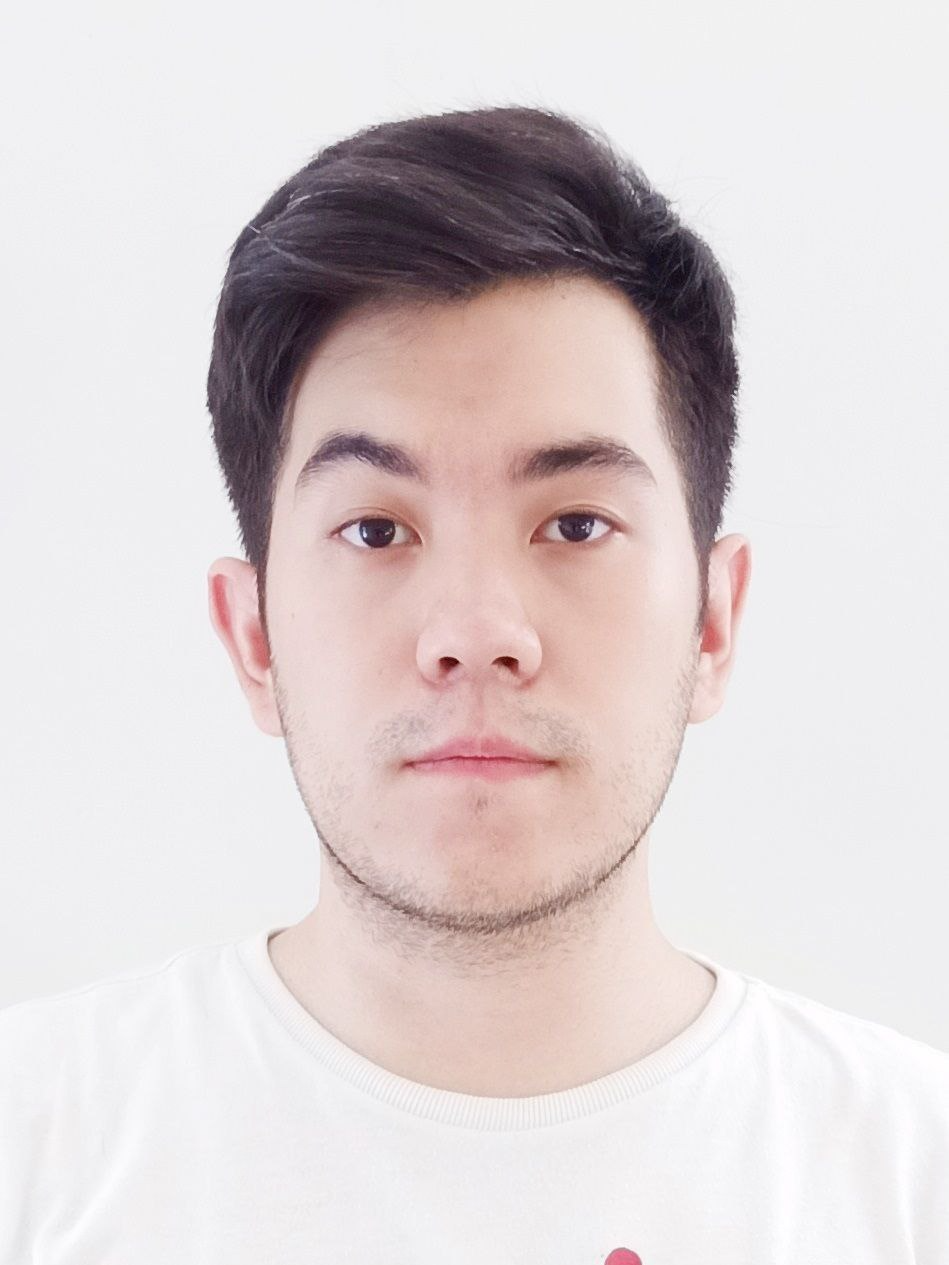

Информация о преподавателе

Нурбек Саиднасим

Data Scientist

Data Scientist

Навыки

С#

ASP .Net

.Net Core

WebAPI

EF Core

Nginx

Azure

Git

Kafka

PostgreSQL

CI/CD

Elasticearch

Linux

Solidity

MSSQL

О проекте

Курс «Data Science: Практика анализа данных и машинного обучения» — это прикладной онлайн-курс, ориентированный на получение востребованных навыков в сфере анализа данных, статистики и машинного обучения. Участники курса с самого начала будут работать с реальными данными и научатся применять инструменты анализа на практике: от загрузки и очистки данных до построения и развертывания моделей машинного обучения.

195 академических часов

Язык обучения – Русский

Длительность курса - 26 недель

Стоимость курса – 600.000 KZT

Процесс отбора студентов предполагает 3 этапа

Тестирование

Прохождение тестового задания.

Мотивационное письмо

Оценка резюме и мотивационных писем.

Интервью

Интервью с преподавателем и куратором курса.

Критерии отбора студентов

-

Выполнение тестового задания должно быть не менее чем на 70% от максимально возможного количества баллов.

-

Получение не менее 7 баллов из 10 при оценке мотивационных писем.

-

Положительное решение о допуске к курсу по итогам интервью с преподавателем и куратором курса.

Тестирование

Прохождение тестового задания.

Мотивационное письмо

Оценка резюме и мотивационных писем.

Интервью

Интервью с преподавателем и куратором курса.

Выполнение тестового задания должно быть не менее чем на 70% от максимально возможного количества баллов.

Получение не менее 7 баллов из 10 при оценке мотивационных писем.

Положительное решение о допуске к курсу по итогам интервью с преподавателем и куратором курса.

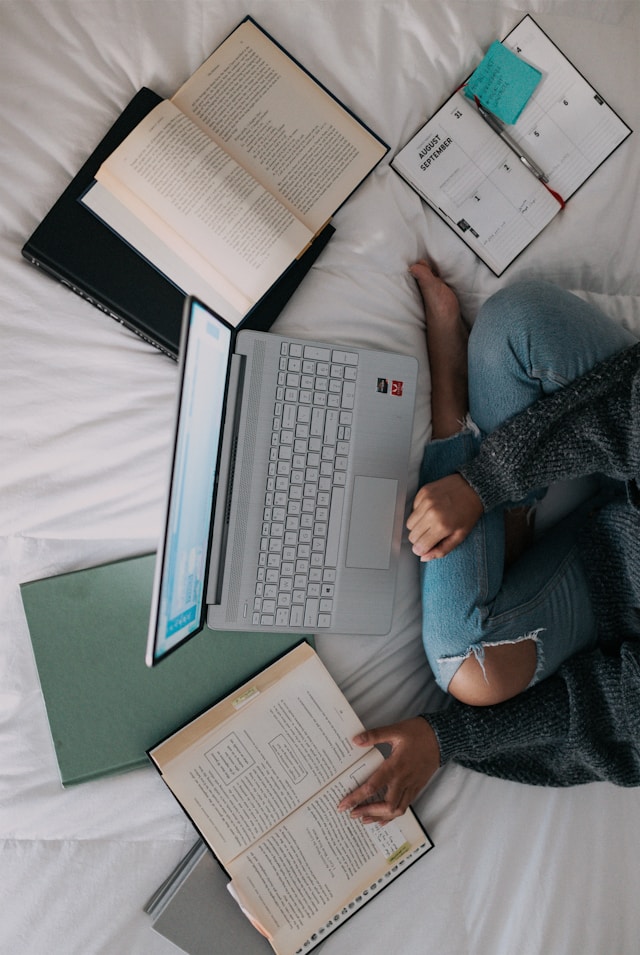

Кому подойдет курс?

Кто уже работает

Кто хочет сменить профессию, и кому требуется удаленная работа в IT-сфере

Студенты

Которые хотят развиваться в новом и современном направлении

Разработчикам

Кто хочет закрепить свои знания практикой

Кто уже работает

Кто хочет сменить профессию, и кому требуется удаленная работа в IT-сфере

Студенты

Которые хотят развиваться в новом и современном направлении

Разработчикам

Кто хочет закрепить свои знания практикой

Программа курса

-

1.1. Настройка среды разработки (Python, Jupyter, VS Code, Git)

-

1.2. Загрузка реальных наборов данных (Kaggle, UCI, открытые API)

-

1.3. Написание скриптов Python для загрузки, анализа и сохранения данных

-

1.4. Использование Git для контроля версий (основные команды)

-

1.5. Практика: загрузить, очистить и сохранить набор данных

-

2.1. Загрузка «грязных» CSV/Excel файлов с кодировками и пропущенными значениями

-

2.2. Умный фильтр, сортировка, группировка больших таблиц

-

2.3. Создание вычисляемых столбцов и показателей (KPI)

-

2.4. Преобразование данных: pivot и melt

-

Практика: очистка и анализ HR или продаж

-

3.1. Создание EDA-ноутбуков и мини-отчетов

-

3.2. Визуализация распределений, выбросов, корреляций

-

3.3. Анализ сезонности, трендов и пробелов в данных

-

3.4. Практика: полный EDA реального датасета (Airbnb, Titanic и др.)

-

4.1. Извлечение признаков из дат, текста, категорий

-

4.2. Бининг числовых признаков в интервалы

-

4.3. Кодирование категориальных признаков (в том числе high-cardinality)

-

4.4. Практика: подготовка признаков для задачи предсказания цен

-

5.1. Построение графиков (гистограммы, боксплоты, тепловые карты)

-

5.2. Создание интерактивных отчетов с помощью Streamlit или Plotly

-

5.3. Практика: построение визуального отчета по реальному датасету (финансы, прокат велосипедов и т.д.)

-

6.1. Построение моделей с использованием scikit-learn

-

6.2. Разделение на train/test, кросс-валидация

-

6.3. Метрики: точность, recall, F1, ROC-AUC, MAE

-

6.4. Практика 1: предсказание оттока клиентов

-

6.5. Практика 2: предсказание цен на жильё или объема продаж

-

7.1. Отбор признаков: какие переменные реально важны?

-

7.2. Настройка гиперпараметров (GridSearchCV, RandomizedSearchCV)

-

7.3. Проверка на переобучение и утечку данных

-

7.4. Практика: тюнинг нескольких моделей и сравнение результатов

-

8.1. Сохранение модели (Pickle, Joblib)

-

8.2. Создание API с помощью FastAPI

-

8.3. Тестирование модели через Postman или простую веб-форму

-

8.4. Практика: развернуть модель скоринга кредита

-

9.1. Сегментация клиентов с помощью k-Means

-

9.2. Снижение размерности с PCA для визуализации

-

9.3. Практика: сегментация клиентов на основе транзакций

-

10.1. Работа с датами и временными индексами

-

10.2. Построение трендов, скользящие средние

-

10.3. Прогнозирование с помощью Prophet или ARIMA

-

10.4. Практика: прогнозирование спроса или трафика

-

11.1. Очистка и нормализация текста (стоп-слова, токенизация)

-

11.2. Векторизация текста (TF-IDF)

-

11.3. Классификация текста (напр. спам или тональность)

-

11.4. Практика: анализ отзывов пользователей или твитов

-

12.1. Выбор своей темы и набора данных

-

12.2. Построение решения от EDA до модели и отчета

-

12.3. Презентация результатов с визуализациями или веб-интерфейсом